Maschinelles Lernen (ML) hat in den letzten Jahren immense Fortschritte gemacht und unsere Welt in vielerlei Hinsicht verändert. Doch der Erfolg solcher Systeme hängt maßgeblich von einer soliden Datengrundlage ab. Ohne hochwertige, gut vorbereitete Daten können Machine-Learning-Modelle keine präzisen Vorhersagen oder Entscheidungen treffen. Lassen Sie uns gemeinsam erkunden, warum diese Grundlage so entscheidend ist, wie Sie Daten optimal vorbereiten und welche Herausforderungen dabei gemeistert werden müssen.

Warum ist die Datengrundlage für Machine Learning so wichtig?

Die Datengrundlage ist das Fundament eines jeden Machine-Learning-Modells. ML-Modelle lernen Muster und Zusammenhänge aus den Daten, die ihnen zur Verfügung gestellt werden. Sind die Daten unvollständig, fehlerhaft oder verzerrt, überträgt sich diese Qualität direkt auf das Modell. Ein Modell kann nur so gut sein wie die Daten, die in das Training einfließen – ein Prinzip, das oft als „Garbage in, garbage out“ bezeichnet wird.

Darüber hinaus sind Daten für maschinelles Lernen nicht nur ein Input, sondern auch eine Möglichkeit, den Kontext und die Bedingungen zu definieren, unter denen ein Modell arbeitet. Die Qualität der Daten beeinflusst die Genauigkeit, Zuverlässigkeit und Robustheit der Ergebnisse. In kritischen Bereichen wie der Medizin oder dem autonomen Fahren könnten Fehler in der Datengrundlage fatale Konsequenzen haben. Mehr über die strategischen Grundlagen erfahren Sie auf unserer Seite zu Machine Learning für Manager.

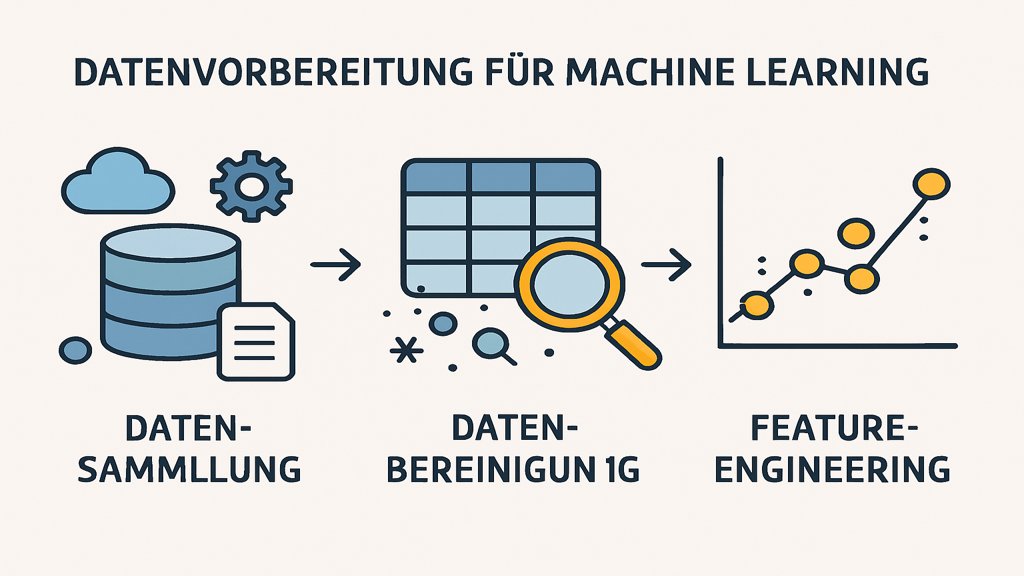

Wie werden Daten für Machine Learning vorbereitet?

Die Vorbereitung von Daten für Machine Learning ist ein mehrstufiger Prozess. Jede Phase spielt eine wichtige Rolle, um sicherzustellen, dass die Daten für das Modell optimal geeignet sind.

Datensammlung: Woher kommen die Daten?

Der erste Schritt besteht darin, die benötigten Daten zu sammeln. Datenquellen können vielfältig sein und reichen von Sensoren über Benutzerinteraktionen bis hin zu öffentlich verfügbaren Datenbanken. Beispiele hierfür sind:

- Web-Scraping: Extraktion von Daten von Webseiten.

- APIs: Zugriff auf strukturierte Daten über Programmierschnittstellen.

- Unternehmensdaten: Interne Datenbanken, die Informationen über Kunden, Produktionen oder Verkäufe enthalten.

- Crowdsourcing: Beschaffung von Daten durch Beiträge von Nutzern.

Die Wahl der Datenquelle hängt stark vom Anwendungsfall ab. Wichtig ist, dass die gesammelten Daten repräsentativ für das Problem sind, das das Modell lösen soll.

Datenbereinigung: Fehler und Inkonsistenzen entfernen

Nach der Sammlung folgt die Bereinigung der Daten. Rohdaten enthalten häufig Fehler, fehlende Werte oder Inkonsistenzen, die das Modell negativ beeinflussen können. Die Datenbereinigung umfasst Schritte wie:

- Entfernung von Duplikaten: Vermeidung von redundanten Informationen.

- Bearbeitung fehlender Werte: Auffüllen oder Entfernen von Lücken in den Daten.

- Korrektur von Anomalien: Identifikation und Behebung von Ausreißern oder falschen Einträgen.

Ein Beispiel: Ein Datensatz könnte fälschlicherweise negative Alterswerte enthalten. Solche fehlerhaften Einträge müssen korrigiert oder entfernt werden. Dieser Schritt ist entscheidend, um sicherzustellen, dass das Modell nicht mit irreführenden Informationen trainiert wird.

Feature-Engineering: Die Daten transformieren

Feature-Engineering ist der Prozess, bei dem Rohdaten in aussagekräftige Variablen (Features) umgewandelt werden, die für das Modell verständlich und nützlich sind. Dieser Schritt umfasst:

- Feature-Scaling: Normalisierung von Daten, damit alle Features im gleichen Bereich liegen.

- Erstellung neuer Features: Kombination vorhandener Daten, um neue, relevante Informationen zu gewinnen.

- Kategorisierung von Daten: Umwandlung von Text- oder Kategorienwerten in numerische Formate, beispielsweise durch One-Hot-Encoding.

Ein Beispiel wäre ein Datensatz mit Datumseinträgen. Anstatt das Datum direkt zu verwenden, könnten daraus Features wie Wochentag oder Quartal generiert werden, wenn diese für die Aufgabe relevant sind. Informationen zu Klassifikationsmethoden finden Sie unter Klassifikationsalgorithmen.

Herausforderungen bei der Datengrundlage für Machine Learning

Die Vorbereitung und Verwendung einer soliden Datengrundlage ist kein einfacher Prozess. Es gibt zahlreiche Herausforderungen, die bewältigt werden müssen.

Datenqualität: Warum sie entscheidend ist

Die Qualität der Daten hat einen direkten Einfluss auf die Ergebnisse eines Modells. Schlechte Datenqualität kann durch verschiedene Faktoren verursacht werden:

- Rauschen: Unregelmäßigkeiten, die die Muster in den Daten verdecken.

- Bias: Verzerrungen, die durch nicht repräsentative Stichproben entstehen.

- Unvollständigkeit: Fehlende Datenpunkte, die das Gesamtbild stören.

Ein Modell, das mit verzerrten oder unvollständigen Daten trainiert wird, kann falsche Schlüsse ziehen. Dies ist besonders problematisch, wenn das Modell in realen Anwendungen eingesetzt wird, bei denen Genauigkeit entscheidend ist.

Datenschutz und ethische Aspekte

Die Sammlung und Verwendung von Daten bringt auch ethische und rechtliche Herausforderungen mit sich. Datenschutzgesetze wie die DSGVO in der EU fordern eine verantwortungsvolle Verarbeitung personenbezogener Daten. Zudem müssen ethische Fragen berücksichtigt werden, um sicherzustellen, dass Modelle keine Diskriminierung oder andere schädliche Auswirkungen verursachen.

Beispielsweise könnte ein Kreditbewertungsmodell unbeabsichtigt rassistische oder geschlechtsspezifische Vorurteile verstärken, wenn die zugrunde liegenden Daten solche Muster enthalten. Transparenz und Fairness bei der Datennutzung sind daher von größter Bedeutung. Weitere Informationen finden Sie in unserem Beitrag zu DSGVO für Unternehmen.

Die Notwendigkeit großer Datenmengen

Maschinelles Lernen, insbesondere Deep Learning, benötigt oft riesige Datenmengen, um leistungsfähig zu sein. Das Sammeln und Verwalten solcher Datenmengen kann jedoch teuer und zeitaufwändig sein. Darüber hinaus können große Datensätze schwer zu speichern und zu verarbeiten sein, was zusätzliche technische Herausforderungen mit sich bringt.

Ein weiteres Problem ist, dass in vielen Anwendungsfällen nicht genügend Daten verfügbar sind. Hier können Techniken wie Datenaugmentation oder synthetische Datengenerierung helfen, die Menge der verfügbaren Daten zu erhöhen.

Best Practices für eine solide Datengrundlage

Um die genannten Herausforderungen zu bewältigen und eine solide Datengrundlage zu schaffen, sollten einige Best Practices beachtet werden:

- Datenquellen sorgfältig auswählen: Achten Sie darauf, dass die Daten repräsentativ, aktuell und zuverlässig sind.

- Automatisierung nutzen: Setzen Sie Tools und Skripte ein, um wiederkehrende Aufgaben wie Bereinigung und Transformation effizient zu gestalten.

- Datenqualität überwachen: Implementieren Sie Mechanismen, um die Qualität der Daten kontinuierlich zu prüfen.

- Datenschutz sicherstellen: Anonymisieren Sie persönliche Daten und halten Sie sich an geltende Datenschutzgesetze.

- Iterativer Ansatz: Überprüfen und verbessern Sie Ihre Datenpipeline regelmäßig, um sicherzustellen, dass sie den aktuellen Anforderungen entspricht.

Eine qualitativ hochwertige Datengrundlage ist der Schlüssel, um das volle Potenzial von Machine-Learning-Modellen auszuschöpfen. Mit sorgfältiger Planung und Umsetzung können Sie sicherstellen, dass Ihre Daten den Anforderungen gerecht werden und Ihr Projekt erfolgreich ist.

FAQ zum Thema Datengrundlage für machine learning

Warum ist die Datengrundlage für Machine Learning so wichtig?

Die Qualität der Daten bestimmt direkt die Leistung und Genauigkeit der Machine-Learning-Modelle. Schlechte Daten führen zu unzuverlässigen Ergebnissen.

Wie kann man Daten für Machine Learning vorbereiten?

Daten müssen gesammelt, bereinigt und transformiert werden. Feature-Engineering und die Auswahl relevanter Daten sind ebenfalls wichtige Schritte.

Welche Herausforderungen gibt es bei der Datengrundlage für Machine Learning?

Herausforderungen umfassen Datenqualität, Datenzugänglichkeit, Datenschutz und die Notwendigkeit großer Datenmengen.